Depois de terem surgido rumores que a Apple estaria a preparar um sistema para identificar conteúdos potencialmente abusivos nos sistemas dos utilizadores, a empresa veio agora confirmar mais detalhes sobre o mesmo.

De acordo com a publicação feita no blog da Apple, esta irá lançar um conjunto de funcionalidades focadas em melhorar as suas plataformas contra casos de abusos de menores. Com o lançamento do iOS 15, watchOS 15 e macOS Monterrey este ano, a empresa lança também um conjunto de medidas de segurança contra abusos de menores nas aplicações de Mensagens, Fotos e na Siri.

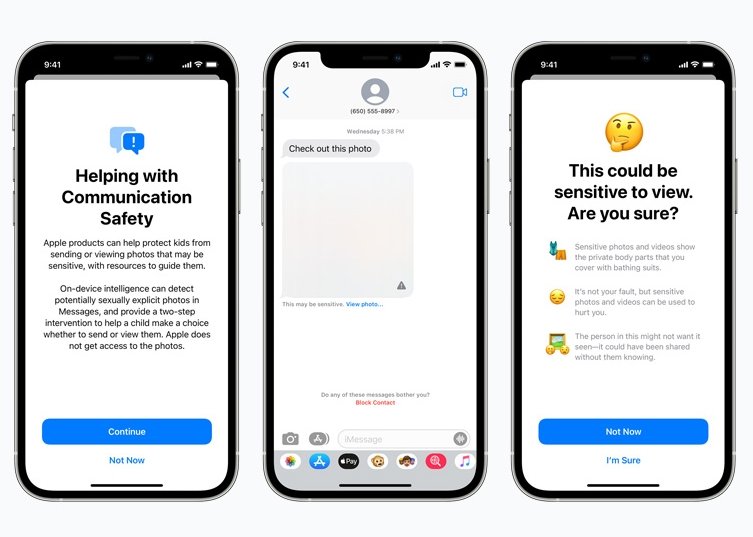

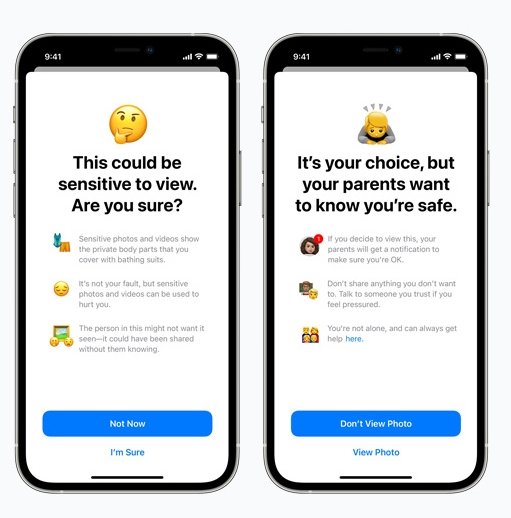

Para começar, sobre a aplicação de mensagens, a aplicação irá agora alertar as crianças e os pais quando estas recebam ou enviem conteúdos que sejam explícitos. Os conteúdos irão surgir na aplicação com um desfoque e vários alertas a informar sobre o conteúdo que é indicado – juntamente com a informação que a partilha de conteúdos sensíveis pode ser perigosa, focada sobretudo no envio.

Além disso, a Apple afirma que este sistema pode também notificar os pais dos menores – caso estejam configurados como tal – caso estes vejam ou enviem o conteúdo mesmo depois dos alertas. A empresa afirma que irá usar os seus sistemas de Machine Learning para identificar estes conteúdos – sem que a Apple tenha acesso direto ao conteúdo das mensagens. Esta funcionalidade vai encontrar-se disponível para contas familiares do iCloud.

Além desta medida, para os utilizadores do iCloud Fotos, a Apple irá agora contar com a integração do sistema de Child Sexual Abuse Material (CSAM), que é capaz de identificar qualquer conteúdo potencialmente abusivo de menores na plataforma – sendo que este sistema é capaz de notificar as autoridades em caso de abusos.

Este sistema usa um conjunto de bases de dados conhecidas de imagens potencialmente abusivas, e compara as mesmas de forma local nos dispositivos dos utilizadores, sem comprometer a sua privacidade. Caso um destes conteúdos seja identificado, a Apple será alertada da situação para tomar as respetivas medidas em conformidade.

A empresa sublinha que o sistema processa toda a identificação de conteúdos num formato automático e baseado em hashs conhecidas de outro material abusivo. No caso de um determinado valor ser acima do considerado “aceitável”, a Apple é então notificada sobre o caso.

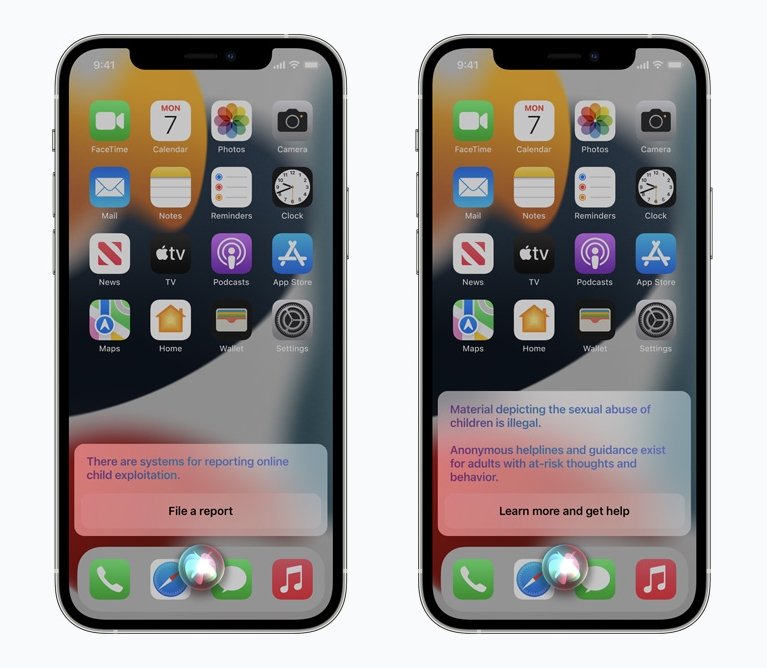

Por fim, este sistema irá também ser integrado diretamente com a Siri e o sistema de pesquisa da Apple. Quando os utilizadores realizem a pesquisa de termos que possam ser considerados abusivos dentro dos parâmetros do CSAM, o sistema notifica o mesmo ao utilizador.

No exemplo deixado pela empresa, o dispositivo pode informar o utilizador que se encontra a realizar a pesquisa de conteúdo abusivo e ilegal, dando a possibilidade de também contactar linhas de apoio direto para estes casos.

Todas estas funcionalidades devem chegar nas próximas versões dos sistemas da Apple, para os diferentes dispositivos da empresa.

Nenhum comentário

Seja o primeiro!