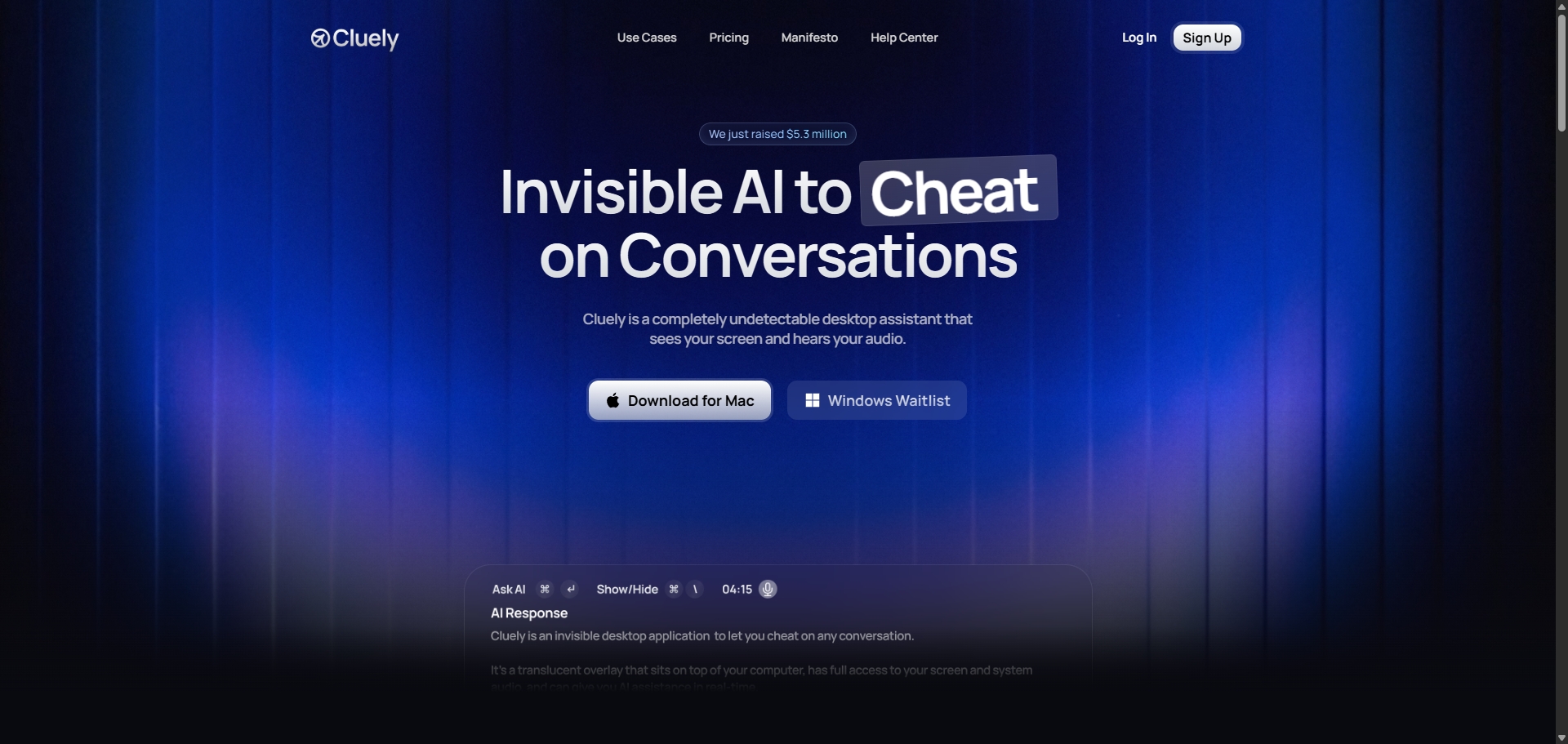

No mundo da inteligência artificial, surgem ferramentas para os mais variados fins, mas poucas assumem um propósito tão controverso como a Cluely. Esta nova plataforma de IA foi explicitamente desenhada para ajudar os seus utilizadores a contornar avaliações, seja em exames académicos ou entrevistas de emprego, funcionando como um assistente discreto durante videochamadas.

Com o slogan provocador "Cheat on everything" ("Faça batota em tudo"), a Cluely não esconde as suas intenções. Liderada por Chunging Lee, a empresa por detrás da ferramenta alega já ter garantido mais de 5 milhões de dólares em investimento, sinalizando que, apesar da polémica, existe interesse neste tipo de tecnologia. A sua notoriedade disparou recentemente, impulsionada por um vídeo de demonstração no X (antigo Twitter) que acumulou mais de 10 milhões de visualizações, mostrando a IA em ação num cenário que faz lembrar a série "Black Mirror".

Como funciona a IA da 'batota'?

A promessa da Cluely reside na sua capacidade de operar de forma "indetetável". Segundo os criadores, a ferramenta consegue analisar o conteúdo de uma videochamada em tempo real – lendo o ecrã e processando o áudio da conversa – sem que as plataformas como o Google Meet ou o Zoom, ou os outros participantes na chamada, se apercebam da sua presença. O objetivo é fornecer respostas e sugestões instantâneas ao utilizador.

Os cenários de utilização são variados: desde auxiliar candidatos em entrevistas de emprego que envolvam testes práticos de programação, a fornecer respostas durante provas online ou até mesmo a apoiar equipas de vendas durante reuniões com clientes.

Privacidade e segurança em cheque

A capacidade de operar sem ser detetada levanta, no entanto, sérias preocupações no campo da segurança e privacidade. Para funcionar, a Cluely exige acesso completo ao ecrã e, potencialmente, ao áudio do computador do utilizador. Isto significa que uma quantidade massiva de informação sensível pode estar a ser processada e armazenada.

Fernando de Falchi, gerente de engenharia de segurança da Check Point Software, alerta para os riscos inerentes. Embora as ferramentas de videoconferência possam não detetar ativamente se outra aplicação está a "escutar", o problema reside na gestão dos dados recolhidos. "O utilizador concede permissão a um terceiro para aceder às suas informações, que podem incluir palavras-passe, folhas de cálculo confidenciais e documentos sensíveis", explica Falchi. "Tudo isto será enviado para a nuvem desta ferramenta, mas que garantias existem de que esses dados não serão acedidos por terceiros não autorizados? Existe um risco real de fugas de informação sigilosa".

Adicionalmente, a gravação ou análise de conversas sem o consentimento explícito de todos os intervenientes pode colidir com regulamentos de proteção de dados, como o RGPD (Regulamento Geral sobre a Proteção de Dados) na Europa, acarretando riscos legais significativos para os utilizadores e para a própria empresa.

Implicações na educação e no mérito

Para além das questões técnicas e legais, o impacto de uma ferramenta como a Cluely estende-se à esfera da educação e da ética profissional. A possibilidade de "copiar" facilmente pode minar o processo de aprendizagem e a valorização do conhecimento genuíno.

Emilly Fidelix, professora doutora e especialista em IA aplicada à educação, expressa preocupação quanto à dependência que estas plataformas podem gerar. "O estudante arrisca-se a tornar-se alguém superficial, sem profundidade de conhecimento em áreas importantes, sem repertório cultural ou autonomia intelectual", afirma. Fidelix defende que "as ferramentas devem auxiliar-nos em processos, poupar tempo, e não fazer completamente o nosso trabalho".

Embora outras IAs, como o ChatGPT da OpenAI ou o Gemini da Google, possuam capacidades que podem ser usadas para resolver problemas ou responder a questões de testes, a Cluely distingue-se por ser especificamente comercializada para facilitar a batota. Perante este cenário, Emilly Fidelix sugere que as instituições de ensino precisam de adaptar as suas estratégias. "Ignorar a existência destas plataformas não é solução. É crucial conhecê-las e criar políticas institucionais claras e atualizadas sobre o uso de IA. Os processos formativos e de atualização tornam-se essenciais", conclui.

A Cluely personifica, assim, um dilema ético crescente na era da inteligência artificial: até que ponto devem ser desenvolvidas e utilizadas ferramentas que, por desenho, visam contornar o esforço, a aprendizagem e a avaliação honesta? A resposta a esta questão terá, certamente, implicações profundas no futuro da educação e do trabalho.

Nenhum comentário

Seja o primeiro!