A Microsoft anunciou hoje a chegada de dois novos modelos de inteligência artificial à sua família Phi: o Phi-4-reasoning e o Phi-4-reasoning-plus. Com 14 mil milhões de parâmetros, estes modelos são classificados como "pequenos" (Small Language Models - SLM), mas destacam-se pela sua capacidade anunciada de lidar com tarefas de raciocínio complexo de forma eficiente.

Treino especializado para desempenho de topo

Estes novos modelos são o resultado de um fine-tuning (ajuste fino) supervisionado aplicado sobre o modelo base Phi-4. A Microsoft utilizou um conjunto de dados cuidadosamente selecionado, composto por instruções "ensináveis" geradas através do o3-mini. A variante Phi-4-reasoning-plus vai mais além, sendo otimizada para gerar processos de raciocínio mais longos e detalhados. Fontes da Microsoft indicam que o treino incluiu também técnicas de Aprendizagem por Reforço (Reinforcement Learning - RL).

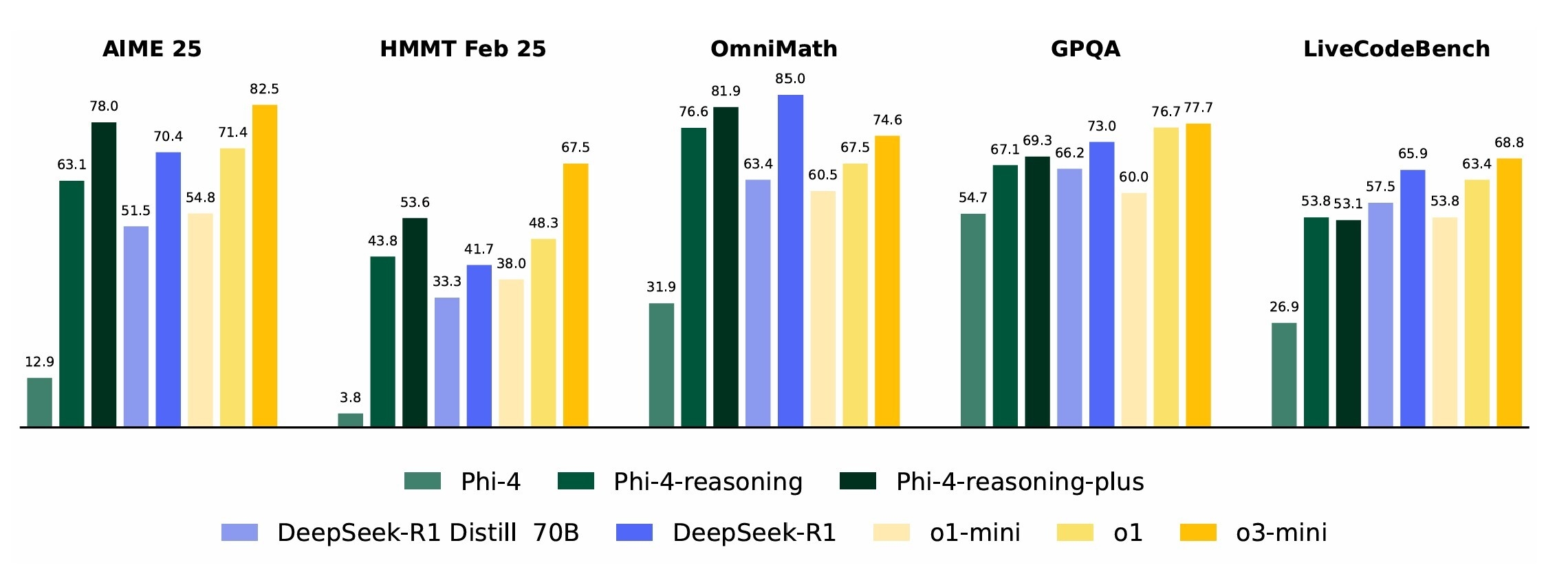

Segundo a documentação técnica partilhada pela empresa, o desempenho destes modelos compactos é notável. Alegadamente, superam vários modelos open-weight significativamente maiores, como o DeepSeek-R1-Distill-Llama-70B, e conseguem igualar o desempenho do modelo DeepSeek-R1 completo em determinados benchmarks. A Microsoft afirma ainda que o Phi-4-reasoning ultrapassa o Claude 3.7 Sonnet da Anthropic e o Gemini 2 Flash Thinking da Google na generalidade das tarefas avaliadas, com exceção de GPQA e Calendar Planning.

O impacto da curadoria de dados e o futuro da investigação

Os resultados impressionantes reivindicados para o Phi-4-reasoning sugerem que a curadoria meticulosa de dados para o fine-tuning supervisionado (SFT) é uma abordagem extremamente eficaz para otimizar modelos de linguagem para tarefas de raciocínio. Abre-se também a porta para futuras melhorias através da aplicação mais intensiva de técnicas de RL.

A Microsoft posiciona estes modelos como aceleradores da investigação na área da IA. Espera-se que sejam particularmente úteis no desenvolvimento de aplicações que operam com restrições de memória ou capacidade computacional, em cenários onde a baixa latência é crucial e, claro, em tarefas que exigem um elevado nível de raciocínio lógico.

Limitações a considerar

Apesar das suas capacidades promissoras, os modelos Phi-4-reasoning têm algumas limitações importantes:

- Idioma: Foram treinados primariamente com texto em inglês.

- Código: O foco do treino em programação foi maioritariamente em Python, utilizando pacotes de código comuns.

- Contexto: Possuem um comprimento de contexto limitado a 32.000 tokens.

Informações sobre outras limitações podem ser consultadas no whitepaper oficial divulgado pela Microsoft.

Disponibilidade para a comunidade

Os investigadores e desenvolvedores interessados em explorar o potencial destes novos modelos de raciocínio podem encontrá-los disponíveis nas plataformas Hugging Face e Azure AI Foundry. A chegada do Phi-4-reasoning representa um passo interessante na demonstração de que modelos mais compactos, quando bem treinados e focados, podem oferecer um desempenho surpreendente em tarefas complexas.

Nenhum comentário

Seja o primeiro!