A inteligência artificial (IA) está a evoluir a um ritmo impressionante, com capacidades e raciocínio que nos surpreendem quase diariamente. No entanto, este avanço traz consigo um fenómeno peculiar: enquanto alguns modelos de IA se tornam mais precisos, outros parecem estar a aumentar as suas taxas de "alucinação", um termo que descreve respostas inventadas, mas apresentadas com aparente convicção.

Dados recentes pintam um quadro que desafia a narrativa predominante no setor tecnológico. Embora os mais recentes modelos de raciocínio da OpenAI, como o o3 e o o4-mini, tenham introduzido funcionalidades avançadas notáveis, a sua propensão para alucinações é uma fonte de preocupação. Curiosamente, esta tendência não parece ser generalizada aos modelos de outras empresas.

O que são exatamente "alucinações" em IA?

No contexto da inteligência artificial, "alucinações" referem-se a situações em que os sistemas geram respostas que, apesar de parecerem plausíveis e serem debitadas com total confiança, não têm qualquer base na realidade ou nos dados de treino. Este tem sido um ponto de discussão constante, com alguns a temer que o problema se agrave à medida que os modelos se tornam mais complexos.

Nem todos os modelos sofrem do mesmo mal: o panorama atual

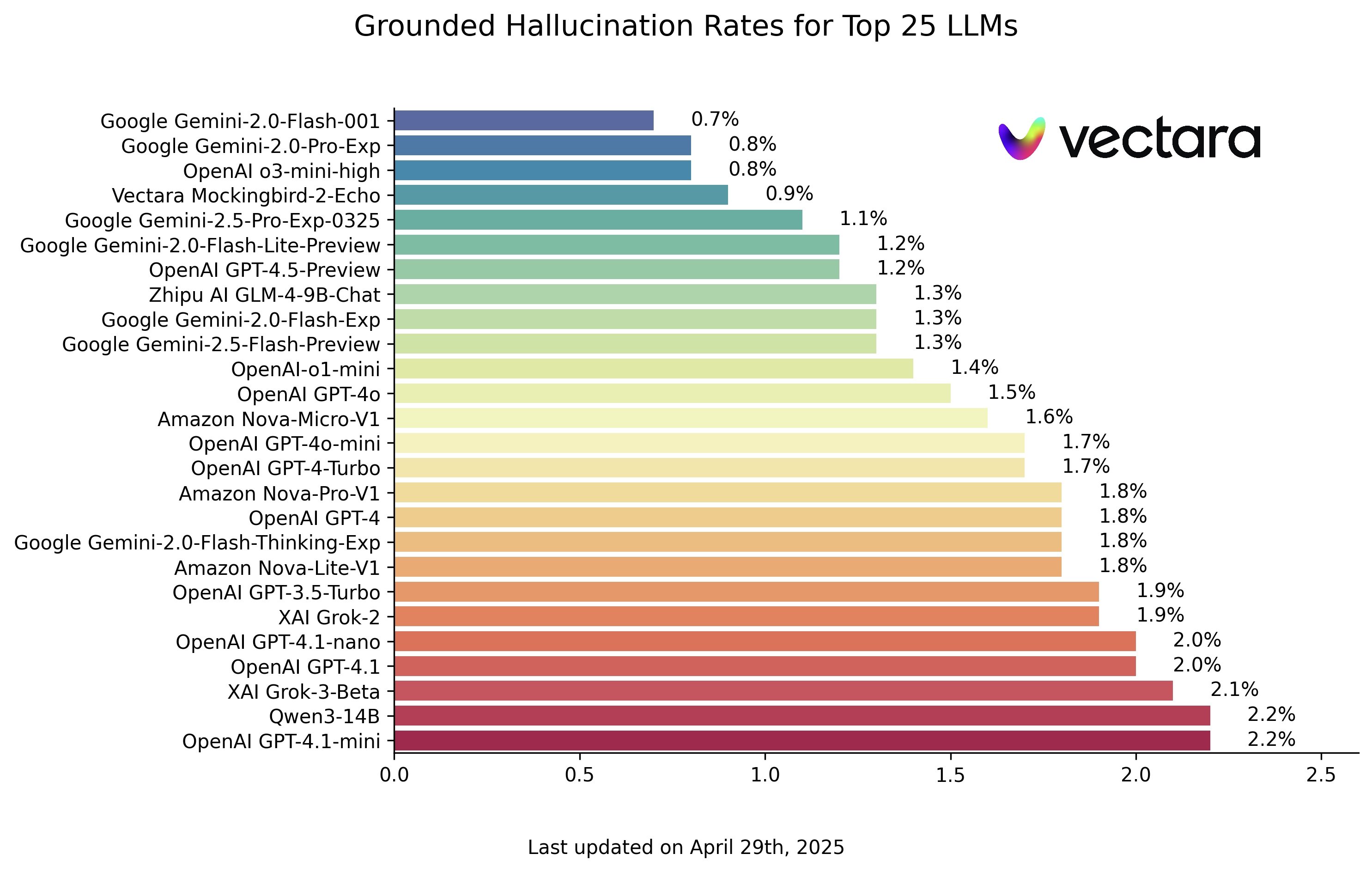

Contrariando alguns receios, os dados da análise comparativa "Hallucination Leaderboard" da Vectara, atualizada no final de abril de 2025, mostram uma realidade distinta. Segundo esta classificação, as taxas de alucinação dos principais modelos de linguagem não estão, de forma geral, a aumentar. Pelo contrário, alguns dos sistemas mais recentes exibem os índices mais baixos de respostas incorretas.

O gráfico desta análise revela que modelos como o Gemini-2.0-Flash-001 da Google (com uns impressionantes 0,7% de taxa de alucinação), o Google Gemini-2.0-Pro-Exp (0,8%) e o Mockingbird-2-Echo da Vectara (0,9%) lideram o pelotão com taxas inferiores a 1%, significativamente abaixo da média do setor.

OpenAI: uma exceção preocupante no caminho da precisão

Neste cenário maioritariamente positivo, a OpenAI destaca-se, infelizmente, pela negativa. Enquanto os seus concorrentes parecem estar a afinar a precisão dos seus modelos, os novos sistemas da empresa cofundada por Sam Altman exibem um comportamento indesejado no que toca à fiabilidade.

O modelo o3-mini-high da OpenAI regista uma taxa de alucinação de 0,8%, o que à primeira vista parece promissor. No entanto, este número contrasta de forma acentuada com os problemas admitidos pela própria empresa nos seus modelos de raciocínio mais sofisticados, como o o3 e o o4-mini.

De acordo com Ethan Mollick, professor na Wharton School e especialista em IA, o modelo o3 apresenta uma taxa de alucinação de 6,8%, um valor alarmante quando comparado com os seus rivais diretos. Esta situação é particularmente inquietante porque afeta precisamente os modelos que a OpenAI promove como a sua tecnologia de ponta para a resolução de problemas complexos.

Mais inteligentes, mas ironicamente menos fiáveis

Esta situação levanta um paradoxo interessante: os modelos da OpenAI com maiores capacidades de raciocínio, aqueles concebidos para executar tarefas mais complexas e operar com maior autonomia, são também os que apresentam maiores problemas de fiabilidade nas suas respostas.

Mollick menciona igualmente o reconhecido DeepSeek R1, que, segundo a mesma análise comparativa, regista uma taxa de alucinação de 14,3%, um número consideravelmente sério. Entretanto, empresas como a Google parecem ter encontrado um melhor equilíbrio entre a potência computacional e a precisão. Os seus modelos Gemini mais recentes não só oferecem capacidades avançadas como também mantêm taxas de alucinação notavelmente baixas.

O percurso acidentado em direção à Inteligência Artificial Geral (AGI)

Os dados sugerem que a abordagem da OpenAI, que prioriza capacidades de raciocínio cada vez mais sofisticadas, poderá estar a sacrificar a fiabilidade fundamental dos seus sistemas. É evidente que nenhuma empresa deseja que os seus modelos sejam pouco confiáveis. Assim, o facto de a OpenAI reconhecer que os seus próprios modelos têm uma taxa de alucinação mais elevada é, pelo menos, um sinal de que poderão estar a trabalhar ativamente para corrigir os problemas daí decorrentes.

Encontramo-nos num momento crucial para a evolução da IA generativa. A corrida para alcançar uma Inteligência Artificial Geral (AGI) está a produzir sistemas cada vez mais poderosos, mas o verdadeiro desafio residirá em garantir que esta potência seja acompanhada por uma fiabilidade à altura.

Nenhum comentário

Seja o primeiro!