A corrida pela supremacia da Inteligência Artificial (IA) continua ao rubro em 2025, e a China acaba de fazer uma jogada de mestre que promete agitar o mercado. A DeepSeek, sediada em Hangzhou, revelou os seus mais recentes trunfos: os modelos DeepSeek-V3.2 e DeepSeek-V3.2-Speciale. A promessa é audaz, com a empresa a garantir que estes novos sistemas conseguem igualar, e em alguns casos superar, os gigantes ocidentais no raciocínio complexo.

Desempenho de ouro contra os gigantes da indústria

A DeepSeek não poupou nas comparações diretas durante o anúncio. Segundo a empresa, o modelo standard V3.2 já consegue igualar o desempenho do GPT-5 em diversos testes de raciocínio. No entanto, é a versão "Speciale" que está a captar todas as atenções. Este modelo foi desenhado para elevar a fasquia, atingindo um nível comparável ao do poderoso Gemini 3 Pro da Google.

Os resultados apresentados são impressionantes. O DeepSeek-V3.2-Speciale conquistou o equivalente a medalhas de ouro em competições de prestígio, incluindo as Olimpíadas Internacionais de Matemática e de Informática de 2025, bem como nas finais mundiais do ICPC 2025. Estes feitos colocam a startup chinesa numa posição de confronto direto com a OpenAI e outras líderes do setor, provando que o fosso tecnológico pode estar a fechar-se mais rápido do que o previsto.

Uma IA que "pensa" enquanto usa ferramentas

A grande inovação técnica por trás destes modelos reside na forma como integram o raciocínio com a utilização de ferramentas. Ao contrário de iterações anteriores, o DeepSeek-V3.2 consegue manter um processo de raciocínio interno ativo enquanto executa tarefas externas, como pesquisas na internet, cálculos ou desenvolvimento de código.

Este "monólogo interior" lógico permite ao modelo resolver problemas complexos de forma mais autónoma e eficaz. O sistema opera com duas modalidades: uma com raciocínio visível (semelhante ao conceito de "cadeia de pensamento" ou Chain-of-Thought), e outra onde o processo ocorre nos bastidores. Um detalhe importante é que esta cadeia de pensamento persiste entre diferentes chamadas de ferramentas, reiniciando apenas quando o utilizador introduz uma nova instrução.

Para tornar isto viável sem custos proibitivos, os engenheiros desenvolveram a arquitetura DeepSeek Sparse Attention (DSA). Embora o modelo possua um total colossal de 671 mil milhões de parâmetros, apenas 37 mil milhões são ativados por cada token processado. Esta eficiência traduz-se numa redução de 50% nos custos de inferência em contextos longos, suportando janelas de até 128.000 tokens.

Transparência total e disponibilidade

Numa atitude que contrasta com a habitual "caixa negra" das grandes tecnológicas norte-americanas, a DeepSeek optou pela transparência. A empresa publicou os pesos completos do modelo e um relatório técnico detalhado sobre o processo de treino, reforçando a sua aposta na comunidade open-source.

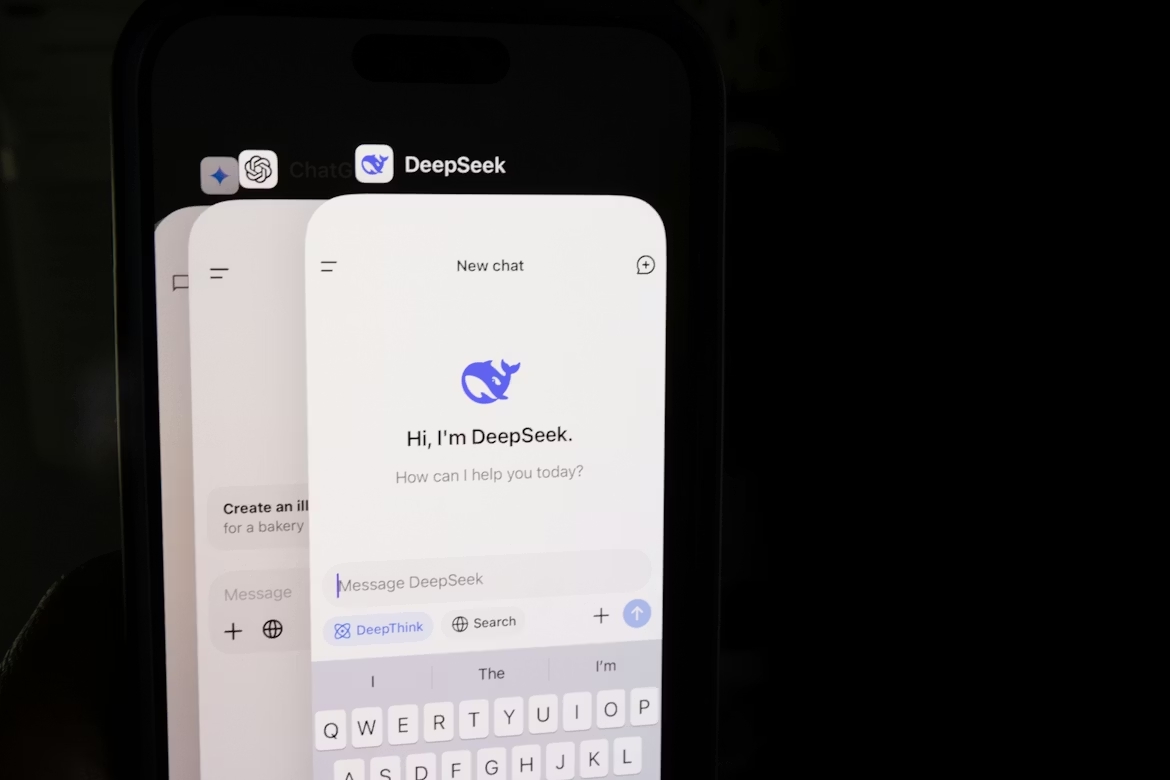

Quanto à disponibilidade, o modelo V3.2 já pode ser acedido através da aplicação oficial, website e API. Já a versão mais potente, o V3.2-Speciale, está disponível por enquanto exclusivamente via API, conforme detalhado no comunicado oficial da DeepSeek. Com esta estratégia, a empresa pretende demonstrar que os modelos de código aberto não só são viáveis, como podem competir no topo da tabela mundial de desempenho.

Nenhum comentário

Seja o primeiro!