A Anthropic, uma das principais rivais da OpenAI, anunciou hoje os seus novos modelos Claude 4. Embora demonstrem melhorias significativas face à geração anterior, Claude 3, em diversos testes de desempenho (benchmarks), a manutenção do limite da janela de contexto nos 200.000 tokens deixou um sabor amargo.

Numa publicação no seu blog oficial, a Anthropic destaca o Claude Opus 4 como o seu modelo mais poderoso até à data, posicionando-o inclusivamente como o melhor modelo da indústria para tarefas de programação.

Desempenho de topo em programação... com um senão

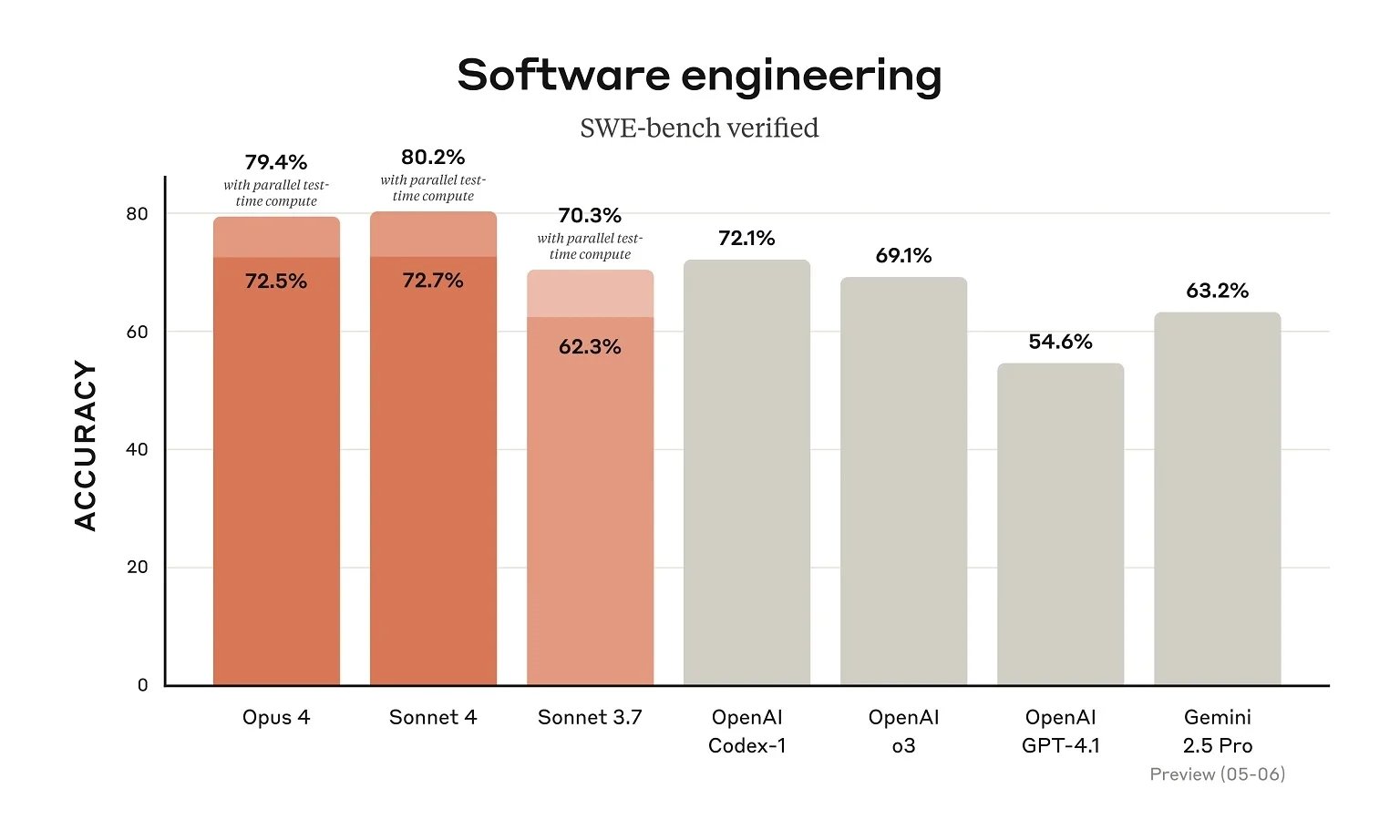

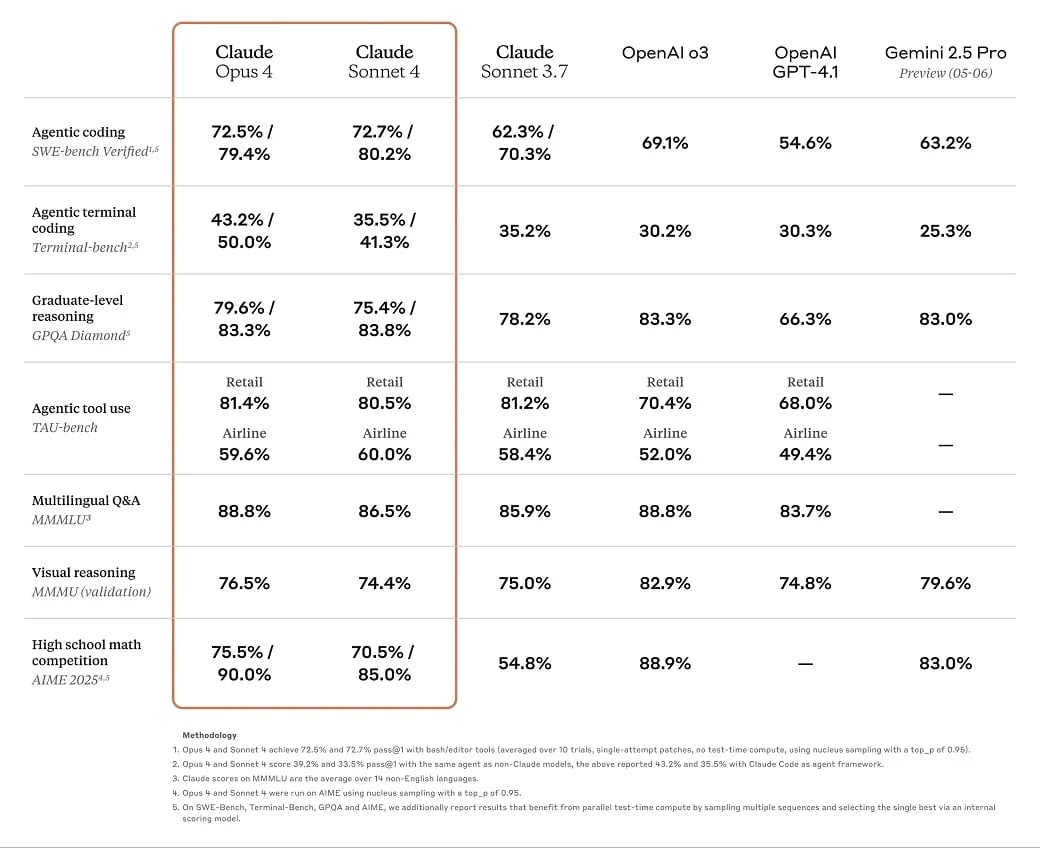

Os números parecem corroborar esta afirmação. Por exemplo, no exigente SWE-bench (Software Engineering Benchmark), o Claude Opus 4 alcançou uma pontuação de 72,5%, e no Terminal-bench registou 43,2%. A empresa sublinha que o novo modelo "entrega um desempenho sustentado em tarefas de longa duração que requerem esforço focado e milhares de passos, com a capacidade de trabalhar continuamente por várias horas, superando dramaticamente todos os modelos Sonnet e expandindo significativamente o que os agentes de IA podem realizar."

Apesar de os benchmarks colocarem os modelos Claude 4 Sonnet e Opus à frente dos seus antecessores e de concorrentes como o Gemini 2.5 Pro da Google no que toca à programação, a limitação da janela de contexto a 200.000 tokens continua a ser uma preocupação notória.

A teimosia dos 200.000 tokens: uma limitação que preocupa

Esta restrição na janela de contexto pode, paradoxalmente, ser uma das razões pelas quais os modelos Claude 4 se destacam nestes benchmarks específicos de programação e resolução de problemas complexos. Muitos destes testes podem não estar a avaliar a capacidade dos modelos contra volumes massivos de informação contextual.

A janela de contexto refere-se à quantidade de informação (medida em tokens, que podem ser palavras ou partes de palavras) que um modelo de IA consegue processar e "lembrar-se" numa única interação. Uma janela maior permite que o modelo compreenda e trabalhe com documentos mais extensos, bases de código mais complexas ou mantenha conversas mais longas e coerentes.

Concorrência já está noutro patamar de contexto

Para efeitos de comparação, o Gemini 2.5 Pro da Google já oferece uma janela de contexto de 1 milhão de tokens, com planos para suportar até 2 milhões de tokens no futuro. Similarmente, os modelos mais recentes da família ChatGPT 4, como o GPT-4 Turbo, também disponibilizam janelas de contexto que podem ir até 1 milhão de tokens.

Face a estes números, o Claude continua a ficar para trás no que diz respeito à janela de contexto, um aspeto cada vez mais crucial para lidar com projetos de grande escala e complexidade, onde a capacidade de processar e reter grandes volumes de informação é fundamental. Esta limitação pode, assim, condicionar a sua aplicabilidade em cenários mais exigentes que os seus concorrentes já conseguem endereçar.

Nenhum comentário

Seja o primeiro!