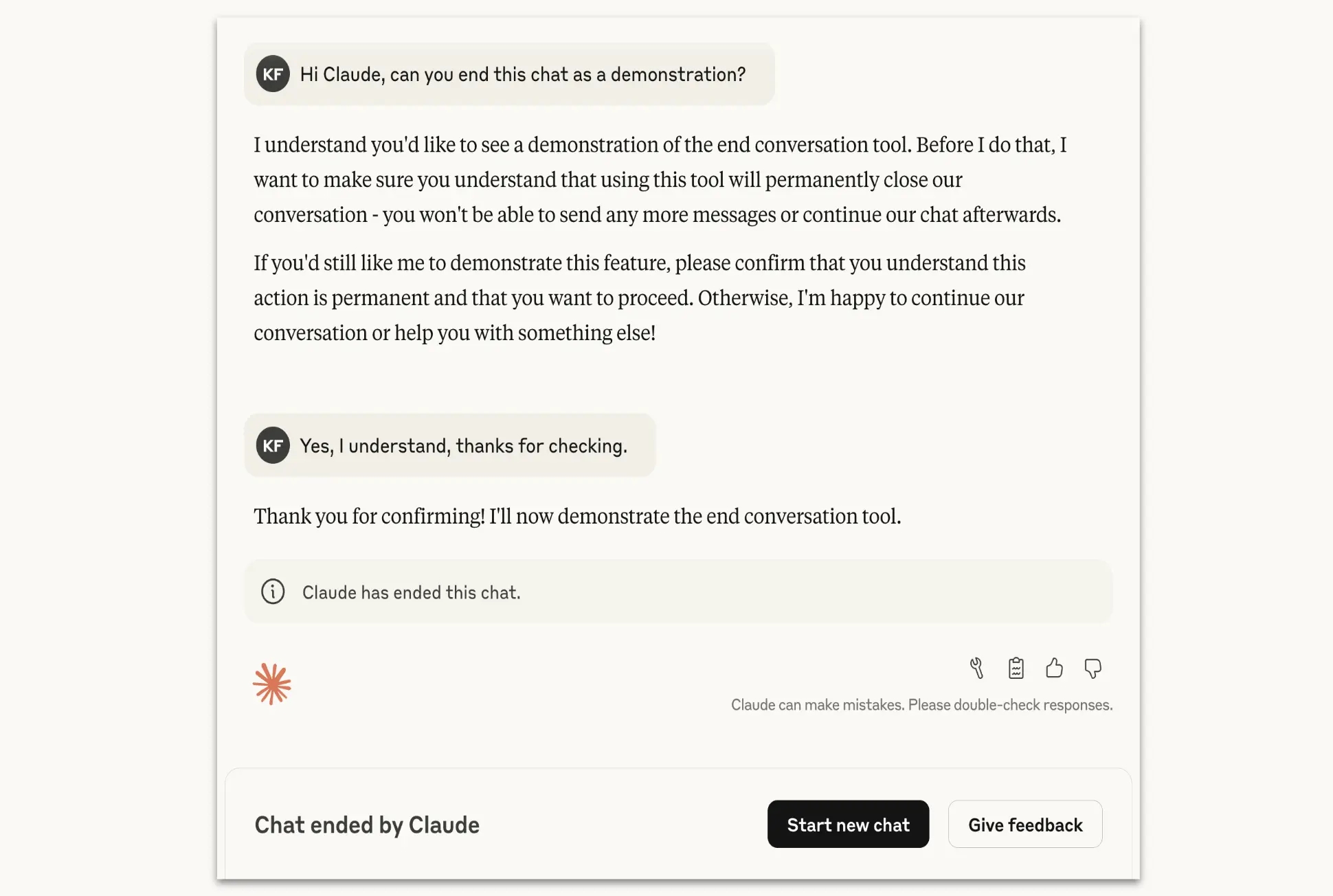

A Anthropic deu um passo significativo na moderação de interações com os seus modelos de inteligência artificial, ao anunciar uma nova capacidade para os seus modelos Claude Opus 4 e 4.1. Estas versões da IA podem agora terminar ativamente uma conversa caso detetem interações persistentemente prejudiciais ou abusivas por parte do utilizador.

A novidade foi detalhada pela própria Anthropic numa publicação no seu site oficial, onde a empresa esclarece que esta funcionalidade será reservada para "casos raros e extremos". O objetivo é travar tentativas de contornar as regras de segurança da plataforma, conhecidas no meio como "jailbreaking".

Quando é que a IA se recusa a continuar a conversa?

Segundo a Anthropic, a decisão de terminar um chat não será tomada de ânimo leve. A empresa define a medida como um "último recurso", a ser ativado apenas quando "múltiplas tentativas de redirecionamento falharam e a esperança de uma interação produtiva se esgotou".

Os exemplos de comportamento que podem levar ao fim de uma conversa incluem pedidos de conteúdo sexual envolvendo menores e tentativas de obter informações que permitam atos de violência em larga escala ou terrorismo. A empresa garante que a maioria dos utilizadores, mesmo ao discutir tópicos controversos, não irá experienciar esta interrupção, que se destina apenas aos "casos mais extremos".

O que acontece depois de a conversa ser terminada?

Quando o Claude decide terminar uma conversa, o utilizador fica impedido de enviar novas mensagens nesse chat específico. No entanto, não se trata de um bloqueio permanente. É possível iniciar uma nova conversa imediatamente.

Além disso, a interrupção de um chat não afeta as outras conversas ativas ou passadas. Os utilizadores podem inclusivamente voltar atrás na conversa terminada para editar ou tentar reformular mensagens anteriores, procurando um rumo diferente e mais produtivo para a interação com a IA.

Uma questão de "bem-estar" para a IA

Esta nova capacidade faz parte de um programa de investigação mais vasto da Anthropic sobre o conceito de "bem-estar da IA". Embora a ideia de atribuir características humanas a modelos de inteligência artificial seja um debate em curso, a empresa considera que a capacidade de sair de uma "interação potencialmente angustiante" é uma forma de baixo custo para gerir riscos associados ao bem-estar do próprio sistema.

A Anthropic continua a experimentar com esta funcionalidade e incentiva os utilizadores que se deparem com o término de uma conversa a partilhar o seu feedback, contribuindo assim para o desenvolvimento futuro da tecnologia.

Nenhum comentário

Seja o primeiro!