A Opera, entidade responsável pelo navegador com o mesmo nome, encontra-se a lançar uma nova atualização que se foca em integrar modelos LLM locais. Isto permite que os utilizadores possam correr os modelos LLM de forma local, diretamente do navegador.

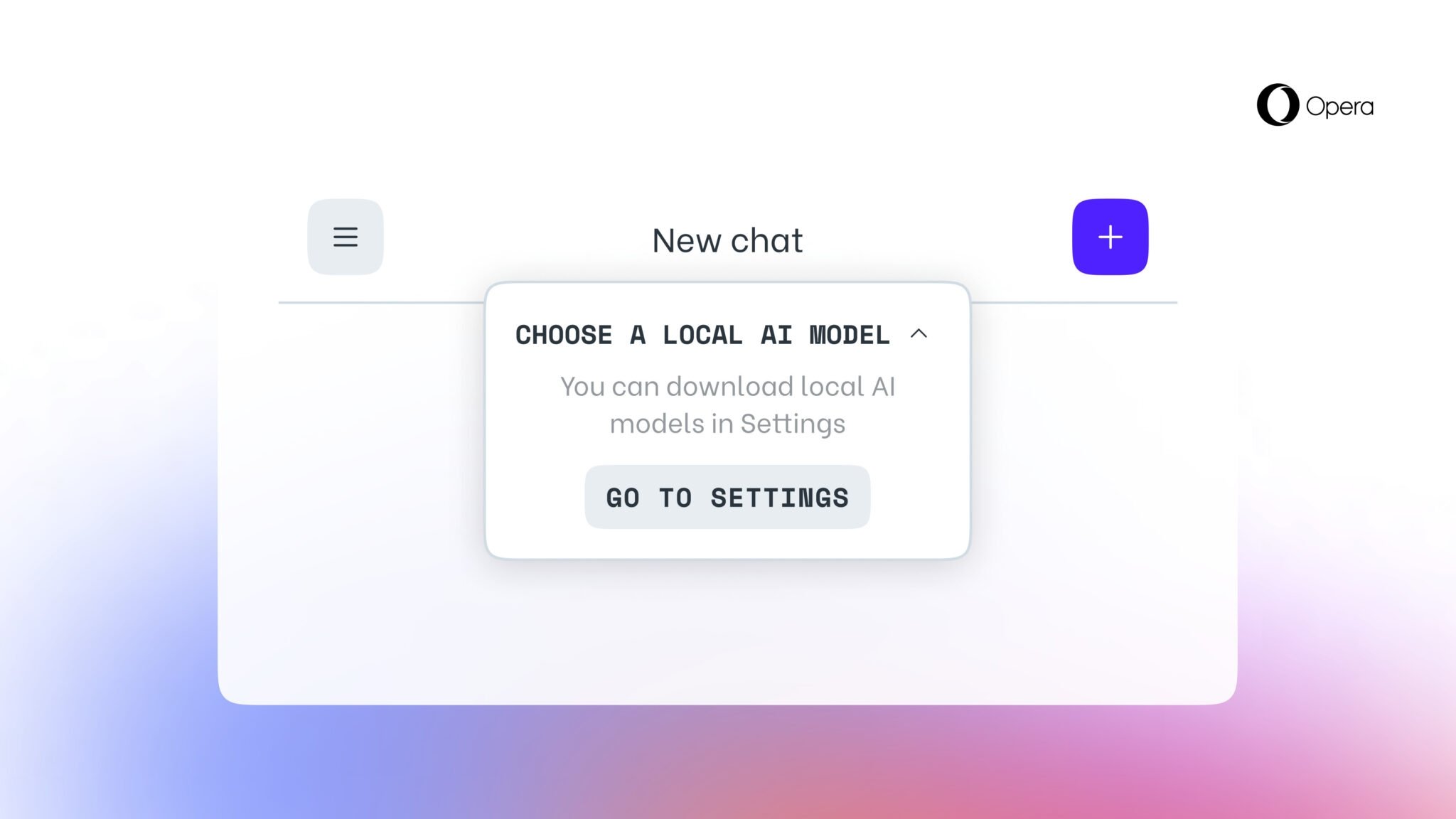

A funcionalidade encontra-se disponível, de momento, para os utilizadores do Opera One Developer, a versão de teste do navegador da empresa. Com esta, os utilizadores podem rapidamente correr vários modelos LLM de forma local, diretamente dos seus sistemas, sem terem de recorrer a plataformas cloud para a tarefa.

Isto terá vantagens, como o facto dos dados apenas serem processados localmente, o que garante mais privacidade e segurança. No entanto, os utilizadores necessitam de ter hardware capaz de processar os dados corretamente, ou a velocidade de processamento será consideravelmente inferior ao que se verifica em plataformas online.

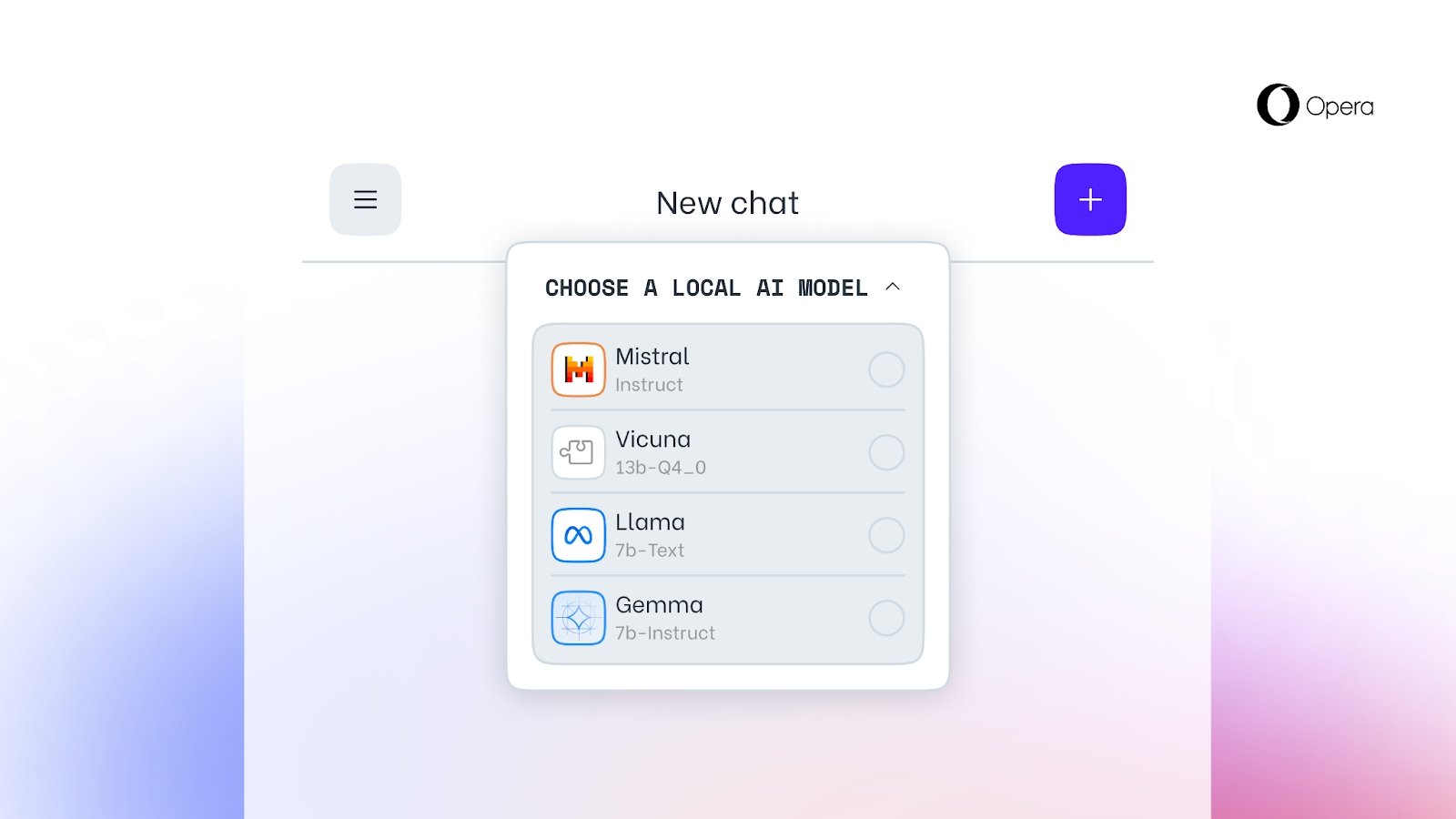

Os utilizadores podem testar modelos LLM como o Llama, Gemma, Mixtral, entre outros. Os dados são processados apenas de forma local, sendo que a Opera garante que nenhuma informação é enviada de forma externa. No entanto, para usar cada modelo, é necessário descarregar os mesmos para os sistemas. Dependendo do mesmo, o tamanho final do modelo LLM pode variar entre 2 a 10 GB.

Quando o LLM se encontra descarregado, este substitui o Aria, o assistente de IA que se encontra por padrão no Opera.

Por enquanto a novidade apenas se encontra disponível para o Opera One Developer, sendo ainda desconhecido quando será lançada para outras variantes do navegador ou para os utilizadores em geral.

Nenhum comentário

Seja o primeiro!