Desde que lançou o novo design da sua aplicação Firefly em abril, a Adobe tem mantido um ritmo quase mensal de grandes atualizações para o seu hub de inteligência artificial generativa. Hoje, a empresa introduz um conjunto de novas funcionalidades focadas em apoiar os utilizadores das capacidades de vídeo do Firefly.

Gerar som com a ajuda da sua própria voz

Para começar, a Adobe está a simplificar a adição de efeitos sonoros aos clipes gerados por IA. Atualmente, a maioria dos modelos de vídeo cria gravações sem qualquer áudio. A Adobe aborda esta questão com uma funcionalidade engenhosa que permite ao utilizador descrever primeiro o efeito sonoro que pretende e, em seguida, gravar-se a si mesmo a produzi-lo. Esta segunda parte não serve para que o modelo imite o som, mas sim para que o sistema compreenda melhor a intensidade e o timing que o utilizador deseja para o efeito.

Na demonstração apresentada, um dos funcionários da Adobe usou a ferramenta para adicionar o som de um fecho de correr a ser aberto. O som que produziu, "zzzztttt", foi fielmente utilizado pelo modelo da Adobe para reproduzir o efeito no volume pretendido. A tradução foi menos convincente quando o funcionário utilizou a ferramenta para adicionar o som de passos em cimento, embora isso possa não ser um problema se a funcionalidade for usada para ideação, como a Adobe pretende. Para facilitar a sincronização, existe um editor de linha do tempo na parte inferior da interface.

Mais controlo criativo com novas ferramentas

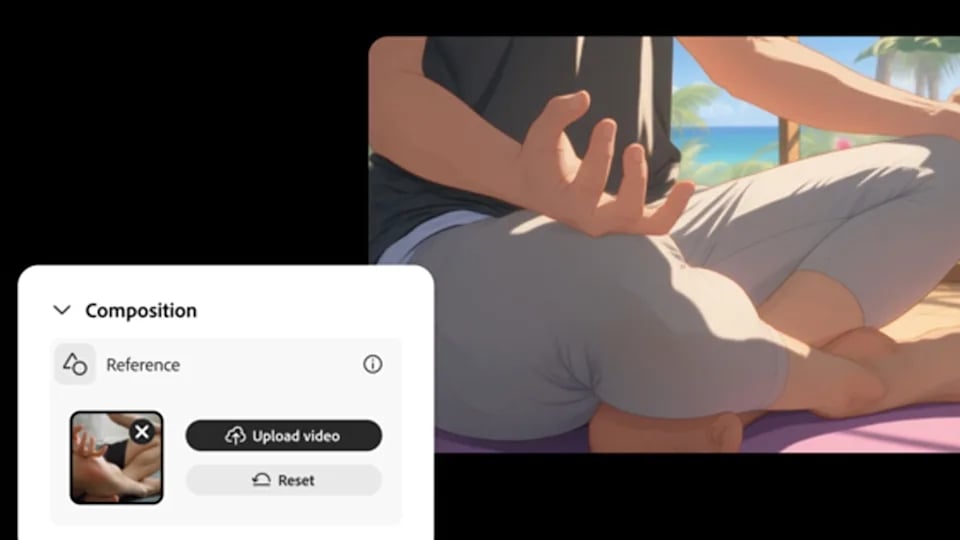

As outras novidades que a Adobe adiciona hoje são o Composition Reference, o Keyframe Cropping e os Video Presets.

Composition Reference: Permite carregar um vídeo ou uma imagem capturada por si para guiar o processo de geração.

Video Presets: Em combinação com a referência de composição, pode definir o estilo do resultado final. Algumas das opções de lançamento permitem criar clipes com estilos de anime, a preto e branco ou arte vetorial.

Keyframe Cropping: Com esta ferramenta, pode carregar o primeiro e o último fotograma de um vídeo e selecionar um rácio de aspeto. O Firefly irá então gerar um vídeo que se mantém dentro do formato desejado.

Integração do Veo 3 e compromisso com a privacidade

Em junho, a Adobe adicionou suporte para mais modelos de terceiros, e este mês continua a fazê-lo. A adição mais notável é a inclusão do Veo 3, que a Google estreou na sua conferência I/O 2025 em maio. Atualmente, o Veo 3 é um dos únicos modelos de IA capazes de gerar vídeo já com som.

Tal como acontece com todos os outros modelos parceiros que a Adobe oferece no Firefly, a Google concordou em não utilizar dados dos utilizadores da Adobe para treinar futuros modelos. Cada imagem e vídeo que as pessoas criam através do Firefly é assinado digitalmente com o modelo que foi usado para o criar. Esta é uma das salvaguardas que a Adobe inclui para que os seus clientes não distribuam acidentalmente um ativo que infrinja material protegido por direitos de autor.

Segundo Zeke Koch, vice-presidente de gestão de produto para o Adobe Firefly, os utilizadores podem esperar que o ritmo acelerado de atualizações continue. "Estamos incansavelmente a lançar novidades quase tão rapidamente quanto conseguimos", afirmou. Koch acrescenta que a Adobe continuará a integrar mais modelos de terceiros, desde que os seus fornecedores concordem com os termos de privacidade de dados da empresa.

Nenhum comentário

Seja o primeiro!