As deepfakes são um problema cada vez mais presente pela internet, e cada vez mais simples de se realizar. Não é difícil ser-se enganado por conteúdo falso criado com recurso a imagens de Inteligência Artificial...

Para combater este problema, e separar os conteúdos reais dos deepfake, um conjunto de empresas criaram uma coligação – liderada pela Adobe – para desenvolver tecnologias capazes de identificar este género de conteúdos, validando se uma foto ou vídeo é verdadeiro.

De acordo com o portal Axios, a Adobe, juntamente com a Microsoft, Arm, Intel TruePic e a BBC, vão anunciar brevemente um standard inicial da tecnologia usada para validar este género de conteúdos. Com esta aprovação, a tecnologia pode ser mais facilmente implementada nos produtos das empresas associadas sem que existam possíveis problemas de compatibilidade.

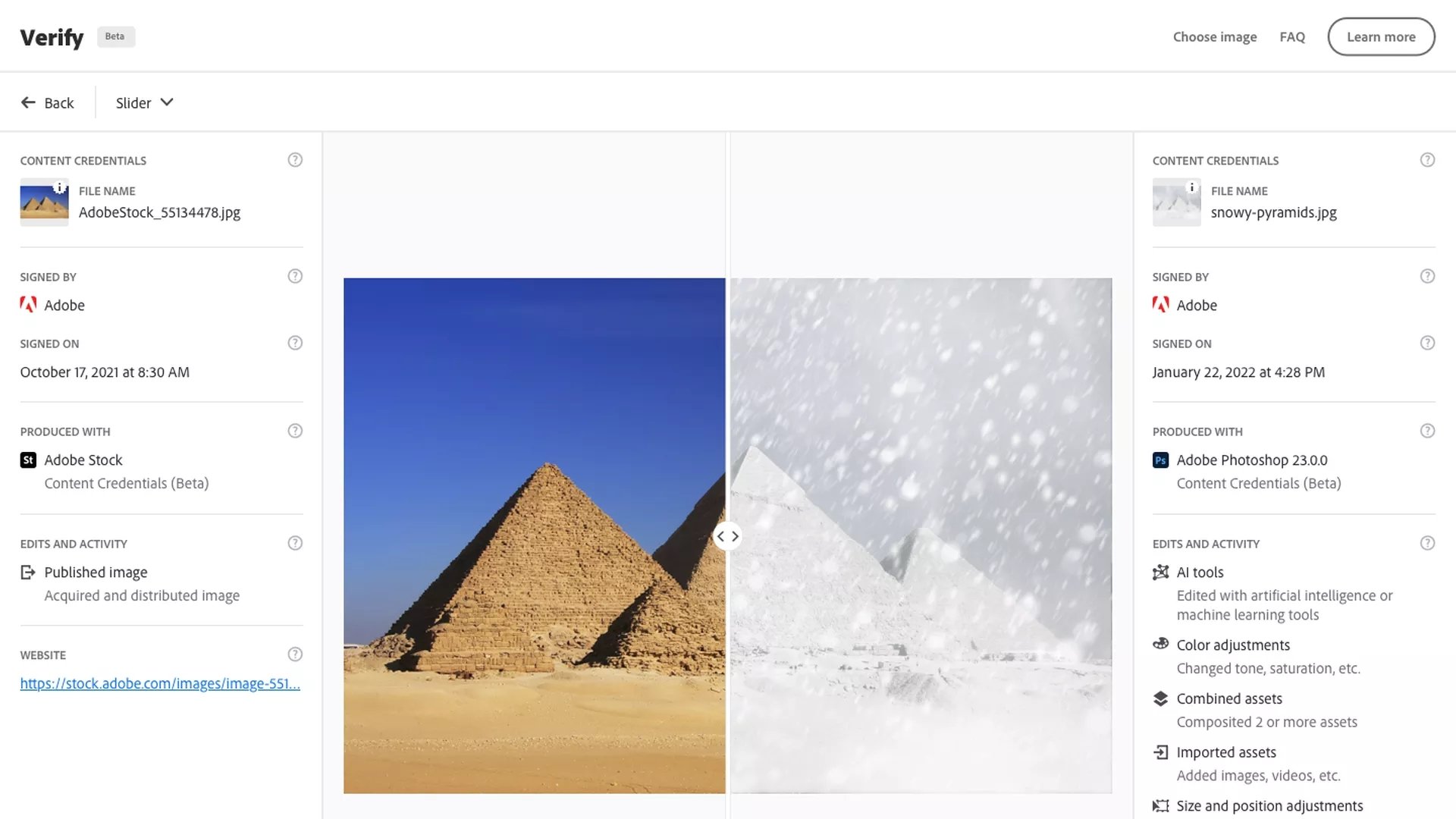

Este novo padrão, desenvolvido durante mais de um ano, vai ajudar no uso de tecnologias que permitem identificar quando uma imagem ou vídeo foi editada, bem como tenta rastrear o conteúdo original e as alterações que foram feitas.

O ano passado, quando a tecnologia ainda se encontrava em desenvolvimento, a Adobe confirmou que a mesma poderia funcionar com o Photoshop, identificando as alterações que tenham sido feitas numa imagem de forma bastante convincente.

De notar que a Adobe pretende disponibilizar esta tecnologia no formato open-source, para que qualquer outra entidade ou interessados possam não apenas melhorar o conteúdo, mas também implementar a mesma nas suas soluções.

Quanto ao futuro, a Adobe refere que se encontra a estudar a possibilidade destas tecnologias de identificação de deepfakes serem também adaptadas para conteúdos de áudio, alargando assim as possibilidades. Isto será ainda mais importante numa altura em que vemos cada vez mais novas tecnologias capazes de criar deepfakes bastante realistas de conteúdos multimédia.

Nenhum comentário

Seja o primeiro!