Desenvolver um videojogo é uma atividade bastante dispendiosa e que consome bastante tempo, sobretudo quando é necessário animar os objetos e personagens no jogo. No entanto, a Nvidia está a desenvolver uma nova tecnologia que pode vir a ajudar bastante quem tenha recursos mais limitados.

Uma das tarefas de animação em videojogos passa por conjugar o movimento da boca das personagens com as suas falas, de forma a tentar ter o movimento mais realista possível. Esta tarefa não é algo fácil de ser feito, mas é exatamente aqui que a Nvidia pretende inovar, ao criar uma tecnologia que utiliza IA para tornar a tarefa consideravelmente mais simples.

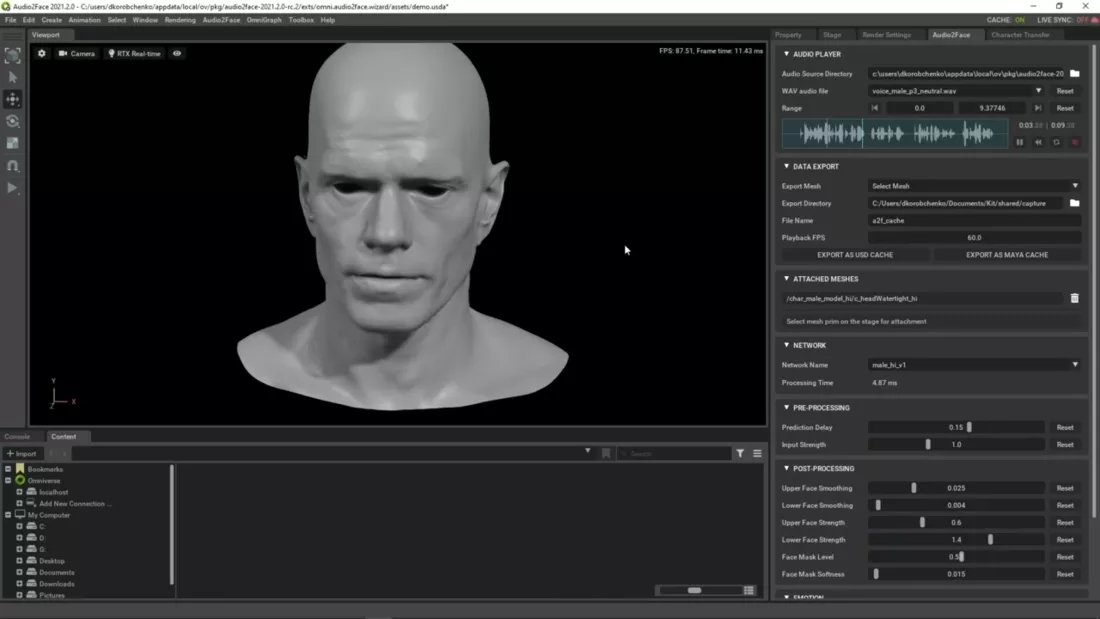

A tecnologia, apelidada de “Audio2Face”, ainda se encontra em beta, mas tem o potencial de ajudar os designers e animadores 3D a criarem modelos realistas de fala em personagens virtuais, usando para tal IA. Esta tecnologia pega nos ficheiros de áudio, analisa os mesmos e tenta transcrever os movimentos das falas para o plano 3D.

Basicamente, a tecnologia adapta automaticamente as falas com o movimento da boca das personagens, sem que tenha de se realizar esta tarefa manualmente. Como se trata de uma tecnologia ainda em fase beta, existem falhas, mas é um primeiro passo que se está a tomar para tornar a tarefa consideravelmente mais simples.

O sistema, de momento, apenas tenta reproduzir os conteúdos com o movimento do rosto, e não simula emoções no mesmo - o que ainda necessita de ser feito manualmente. Mas ainda assim, ter todo o trabalho de sincronizar o movimento da boca com as falas é um trabalho a menos para ser feito.

Esta tecnologia é algo similar ao que a CDPR utilizou em Cyberpunk 2077, apelidada de “JALI”, mas neste caso a mesma tem como base a própria Nvidia e todo o seu conhecimento na área do 3D e Inteligência artificial.

Nenhum comentário

Seja o primeiro!