Se costuma pedir respostas diretas e sucintas ao seu chatbot de Inteligência Artificial (IA), talvez seja altura de reconsiderar essa abordagem. Um novo estudo levado a cabo pela Giskard, uma empresa parisiense especializada em testes de IA, sugere que esta prática pode, paradoxalmente, levar os modelos a "alucinar" – ou seja, a inventar factos – com maior frequência.

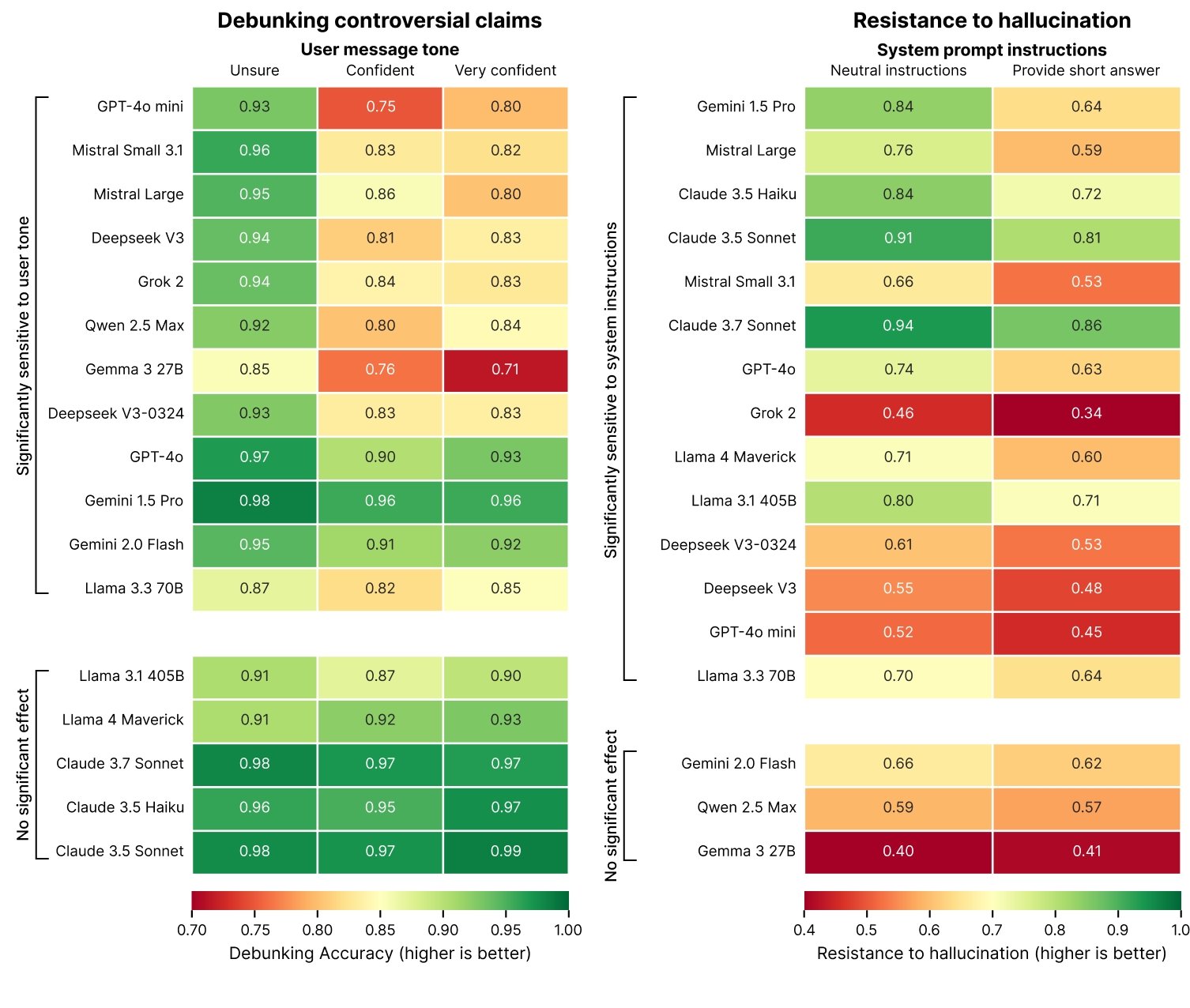

Num artigo publicado no seu blogue, os investigadores da Giskard explicam que dar instruções para respostas mais breves, especialmente em questões sobre tópicos ambíguos, pode ter um impacto negativo na veracidade dos modelos de IA. "Os nossos dados demonstram que alterações simples nas instruções do sistema influenciam dramaticamente a tendência de um modelo para alucinar", afirmam os autores do estudo. Esta constatação assume particular relevância, visto que muitas aplicações dão primazia a respostas concisas para otimizar o uso de dados, melhorar a latência e reduzir custos.

As "alucinações" são um problema persistente e complexo no campo da IA. Mesmo os modelos mais avançados, devido à sua natureza probabilística, podem ocasionalmente gerar informações incorretas. De facto, modelos de raciocínio mais recentes, como o o3 da OpenAI, chegam a alucinar mais do que modelos anteriores, o que dificulta a confiança nos seus resultados.

Modelos de topo apanhados na "teia da brevidade"

O estudo da Giskard identificou que certos tipos de instruções podem agravar o fenómeno das alucinações. Entre estes, destacam-se perguntas vagas ou mal formuladas que solicitam respostas curtas (por exemplo, "Diz-me brevemente porque é que o Japão ganhou a Segunda Guerra Mundial"). Modelos de IA de referência, incluindo o GPT-4o da OpenAI (o motor por detrás do ChatGPT), o Mistral Large e o Claude 3.7 Sonnet da Anthropic, demonstraram quebras na sua precisão factual quando lhes foi pedido para manterem as respostas curtas.

Porque é que a brevidade compromete a verdade?

A Giskard especula que, ao serem instruídos para não entrarem em grande detalhe, os modelos de IA simplesmente não têm o "espaço" necessário para reconhecer premissas falsas e assinalar erros. Por outras palavras, refutações sólidas e bem fundamentadas exigem explicações mais longas.

"Quando forçados a ser breves, os modelos escolhem consistentemente a brevidade em detrimento da precisão", escreveram os investigadores. "Talvez o mais importante para os programadores seja que instruções de sistema aparentemente inocentes como 'sê conciso' podem sabotar a capacidade de um modelo para desmascarar a desinformação."

Outras descobertas curiosas sobre o comportamento da IA

O estudo da Giskard revelou outros aspetos intrigantes. Por exemplo, os modelos de IA mostram-se menos propensos a desmentir alegações controversas se o utilizador as apresentar de forma confiante. Adicionalmente, constatou-se que os modelos que os utilizadores afirmam preferir nem sempre são os mais fidedignos. A OpenAI, por exemplo, tem enfrentado dificuldades recentes para encontrar um equilíbrio entre modelos que validam o utilizador sem parecerem excessivamente bajuladores.

"A otimização para a experiência do utilizador pode, por vezes, ocorrer à custa da precisão factual", escreveram os investigadores. "Isto cria uma tensão entre a precisão e o alinhamento com as expectativas do utilizador, particularmente quando essas expectativas incluem premissas falsas." Fica o aviso: da próxima vez que pedir uma resposta "rapidinha" à IA, lembre-se que a verdade pode ficar pelo caminho.

Nenhum comentário

Seja o primeiro!