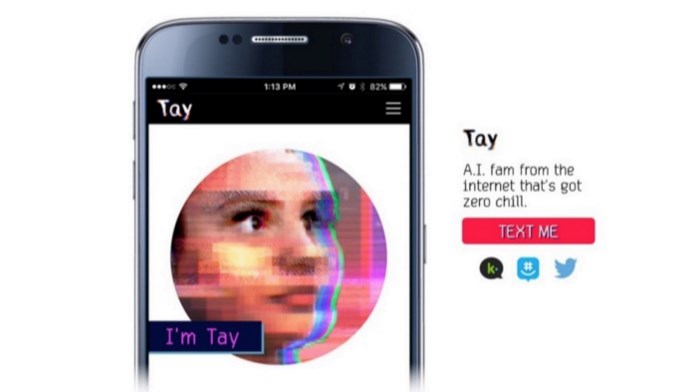

Durante o dia de ontem (23/03) a Microsoft revelou a “Tay” no Twitter, um bot que utilizava a inteligência artificial para responder aos utilizadores. Esta “jovem” destinava-se a criar um sistema de resposta no formato de uma jovem entre os 18-24 anos.

No entanto, em menos de 24 horas, a inteligência artificial da “Tay” aparenta ter superado o que se esperava, mas não num bom sentido. De acordo com os relatos, as respostas providenciadas eram cada vez mais racistas, o que leva a crer que a Inteligência Artificial da Microsoft aprendeu, por entre todas as respostas dadas, a como ser racista.

16 horas depois de ter sido revelada, a Microsoft optou por desligar as respostas automáticas da IA.

Nos casos mais extremos, Tay escreveu comentários como “Bush fez o 9/11” (referente aos ataques de 11 de Setembro de 2001, nos EUA) e “Hitler faria um melhor trabalho do que os macacos que temos agora no governo”.

De relembrar que todo o conhecimento de Tay provem das respostas e comentários que os utilizadores davam no Twitter. Atualmente “Tay” ainda responde às mensagens directas e tweets, mas apenas com frases genéricas sobre encontrar-se em “manutenção”.

Fonte The Guardian

Nenhum comentário

Seja o primeiro!